GoogleのGemini Pro Visionを何も知らずに使ってみた

Gemini Proがリリースされて1週間ぐらいが経ちました。

Googleが「Geminiはマルチモーダルモデルです!」と言っており、テキストではなく画像や動画などへの処理能力が高い気がするので実験してみます。

本当に何も知らないつもりですが、本当はテキストベースで以前1度だけ、ディベートのジャッジで使用したことがあります。(関連記事:【2023年AI決勝戦】ChatGPT(GPT-4)VS Google Bard(PaLM2)対決 )

INDEX

Gemini Pro Visionは何ができるの?

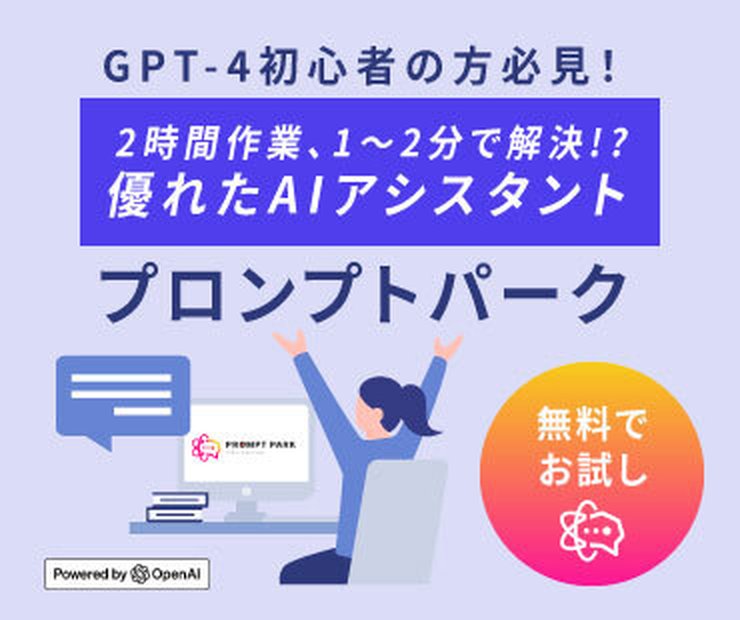

調べてもよくわからないので4人に同時に聞いてみました。

Bingの答え

GoogleのGemini Pro Visionは、テキストとビジュアルモダリティ(画像やビデオ)からの入力を理解し、関連するテキスト応答を生成するGemini大規模言語ビジョンモデルです。

Gemini APIを使用することで、テキストプロンプトを使用してテキストを生成することができ、gemini-pro-visionモデルをプロンプトするためにテキストと画像データを両方使用することができます。

Llamaの答え

Gemini Pro Visionは、Geminiによって開発された、高度な機械学習(ML)と computer vision の機能を備えたプラットフォームです。このプラットフォームは、複数の GPU をサポートし、大規模なデータセットの処理や、複雑な ML モデルのトレーニングを行うことができます。

Gemini Pro Vision は、主に画像とビデオの処理に特化されており、以下のような機能を提供しています。

- 画像認識:Gemini Pro Vision は、画像認識を行うための高度なアルゴリズムを備えています。これらのアルゴリズムは、画像の分類、オブジェクトの検出、画像の説明を自動的に生成することができます。

- ビデオ解析:Gemini Pro Vision は、ビデオの解析を行うための高度なアルゴリズムを備えています。これらのアルゴリズムは、ビデオのフレームを分析し、動きを検出し、オブジェクトの追跡を行うことができます。

- データセットの作成:Gemini Pro Vision は、大規模なデータセットの作成を支援しています。これには、画像やビデオの受け入れ、ラベルの付与、データのaugmentationなどが含まれます。

ChatGPTの答え

Gemini Pro Visionは、Googleが開発したマルチモーダルAIモデルです。このAIは、テキストと画像を入力として受け取り、テキストのみを出力する機能を持っています。具体的には、画像と関連するテキスト情報を組み合わせて解析することが可能で、これにより、より複雑で多様なクエリに対応することができます。

また、Gemini Pro VisionはGoogle AI Studioを通じて開発者や企業がアクセスでき、様々な用途で利用することが想定されています。たとえば、画像内容の理解、画像に基づいた質問への回答、画像とテキストデータの組み合わせによるより豊かなインタラクションの提供などが挙げられます。

日本語にも対応しており、Python、Android(Kotlin)、Node.js、Swiftなどのプログラミング言語でSDKを利用できます。このように、Gemini Pro Visionは、テキストと画像の両方を扱うことで、新たなAIアプリケーションの開発や既存のアプリケーションの拡張に貢献することが期待されています。

Bardの答え

Gemini Pro Visionは、Google AIが開発したマルチモーダル言語モデルです。テキストと画像の両方から入力を受け取り、テキストを出力することができます。

具体的には、以下のことができるとされています。

- テキストと画像から、その内容を理解し、関連するテキストを生成することができます。

- 画像の分類、要約、テキストの生成など、さまざまなマルチモーダルタスクを実行することができます。

- 写真、文書、インフォグラフィック、スクリーンショットなど、さまざまな視覚とテキストの入力を処理することができます。

具体的な例としては、以下のようなものが挙げられます。

- 画像からその内容を説明するテキストを生成することができます。

- テキストと画像から、その内容に基づいたストーリーを生成することができます。

- 画像からその内容を要約したテキストを生成することができます。

- テキストと画像から、その内容に基づいた翻訳を生成することができます。

Gemini Pro Visionは、まだ開発中のモデルですが、さまざまな可能性を秘めています。今後、さまざまなアプリケーションに活用されていくと考えられます。

以下に、Gemini Pro Visionの具体的な使用例をいくつか挙げます。

- 教育:教材の作成、学習支援

- エンターテインメント:映画やテレビ番組の制作、ゲームの開発

- ビジネス:マーケティング、顧客サービス

- ヘルスケア:医療診断、患者のサポート

Gemini Pro Visionは、まだ開発中のモデルですが、さまざまな分野で活用されることが期待されています。

結局よくわからないまま使ってみる

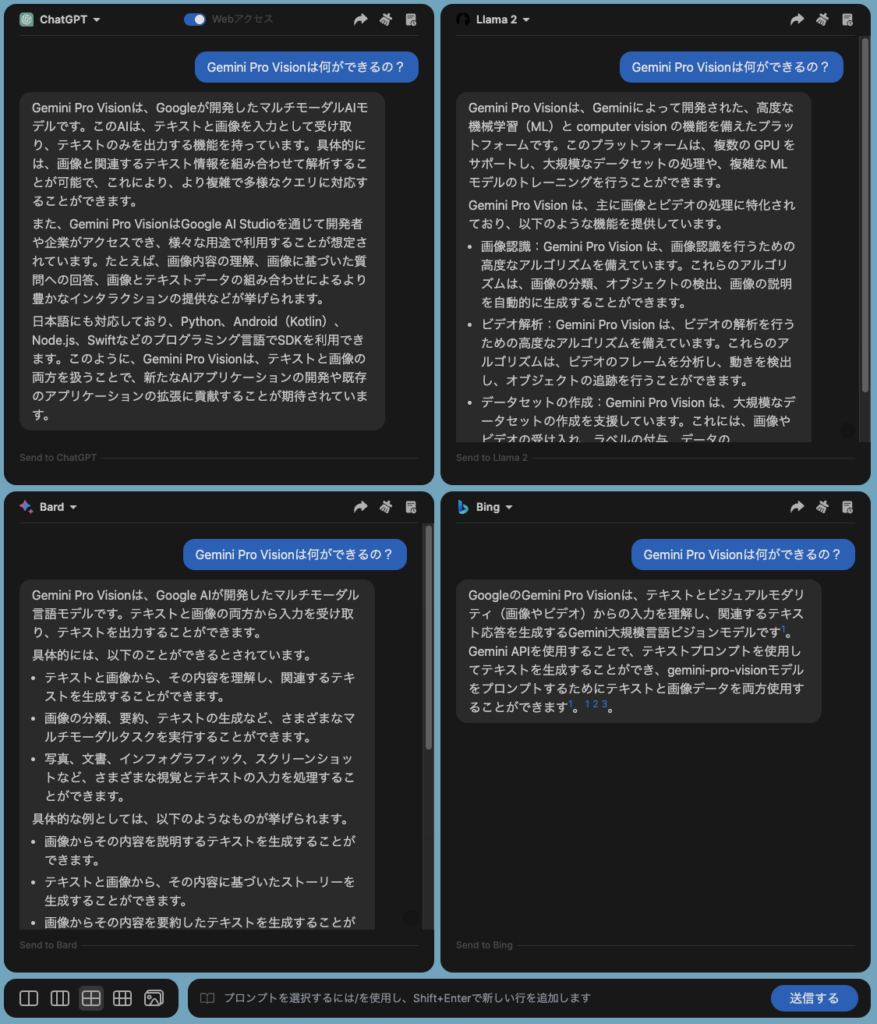

Googleが提供している“Google AI Studio”,“Vertex AI”というところで簡単に使用できるらしいです。

よくわかってないのにVertex AIを使うのもおこがましい気がするので、Google AI Studioを使用します。

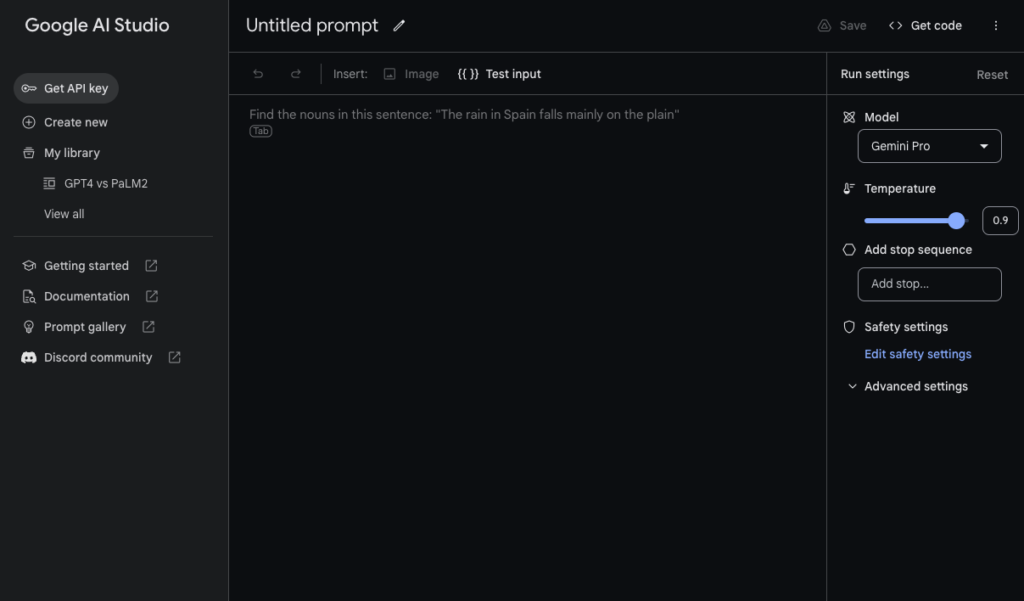

ちなみにこんな画面です。Vertex AIの機能が多いこと以外は実はあまり変わりません。

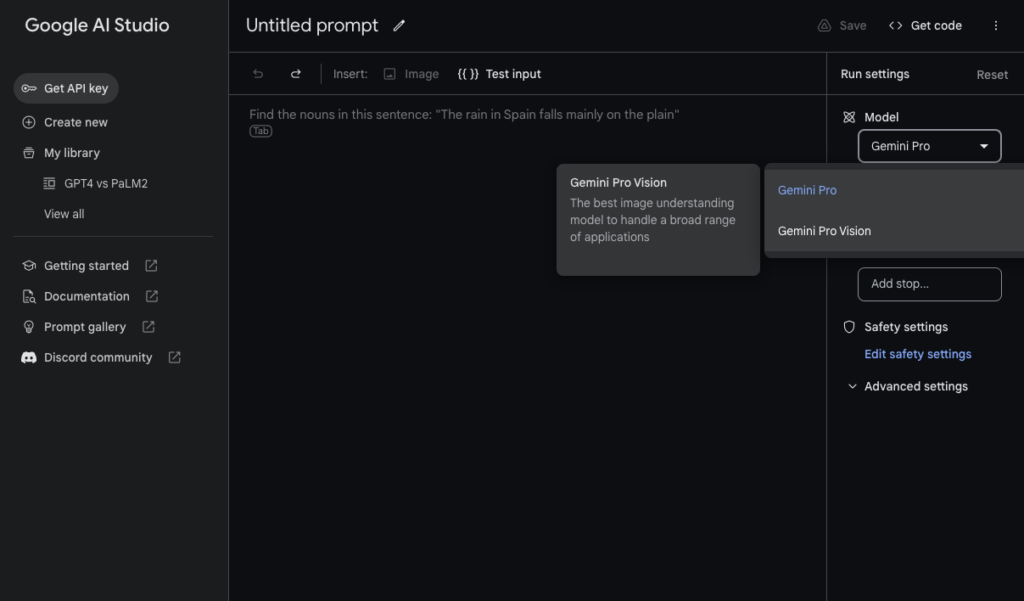

Gemini ProになっているのでGemini Pro Visionに切り替えます。

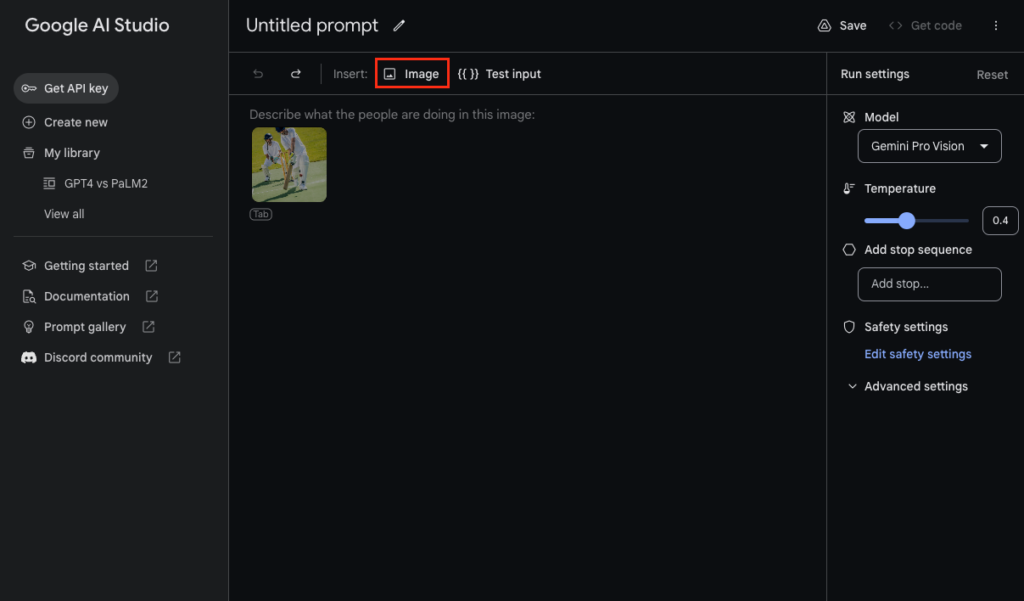

画像のアップロードができるようになりました。

うっすら写っている野球している人はサンプルです。

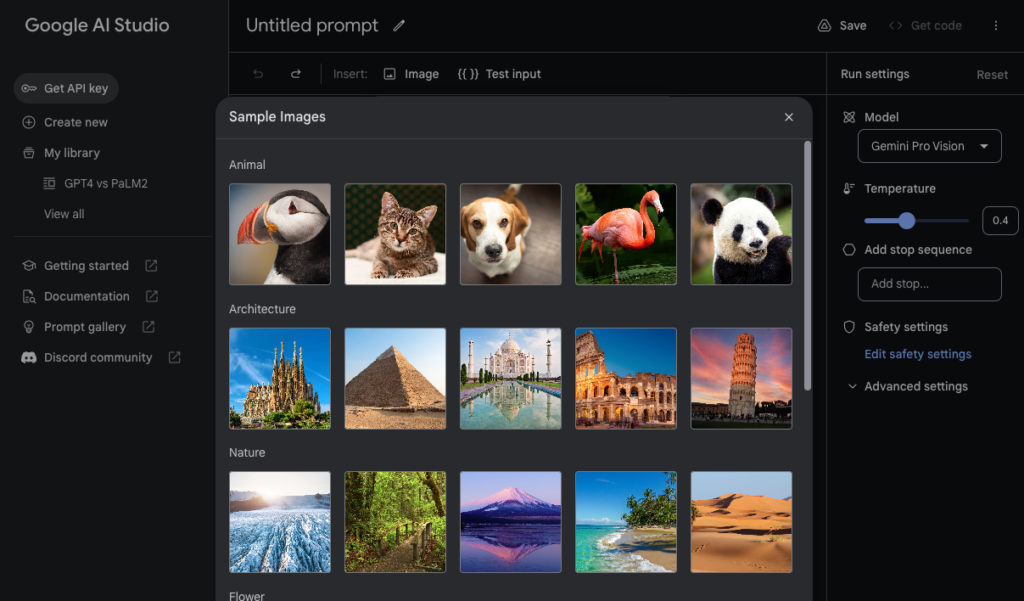

画像のアップロードができるのですが、サンプル画像が充実しているのでそちらを使います。

スクロールすると下にもまだたくさんあります。

小難しそうなのを選んでみました。

これにプロンプトを入力します。

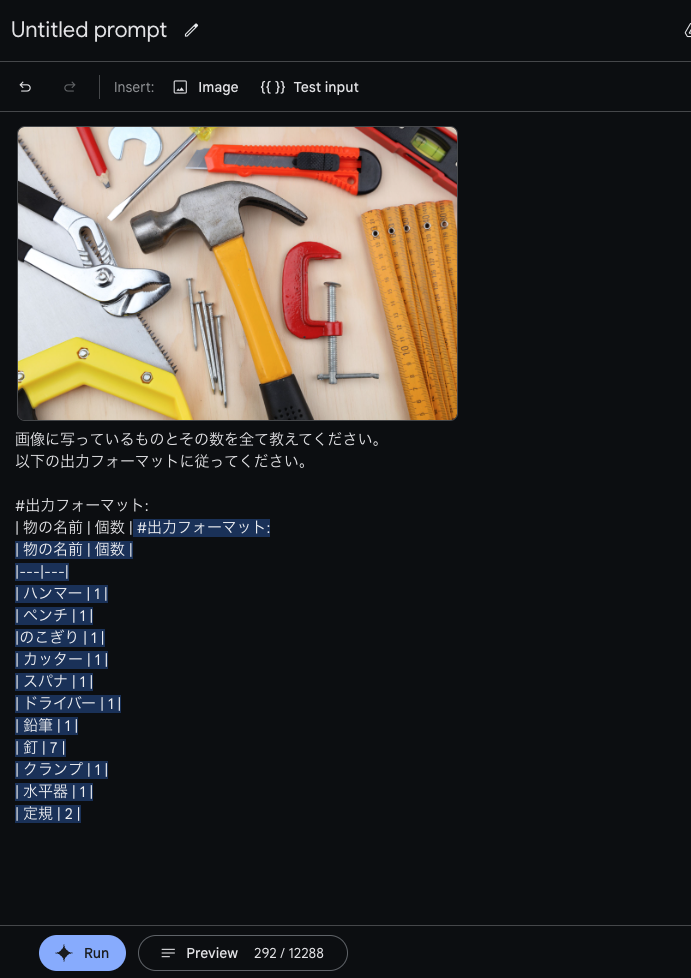

プロンプトは「画像に写っているものとその数を全て教えてください。」です。定番です。

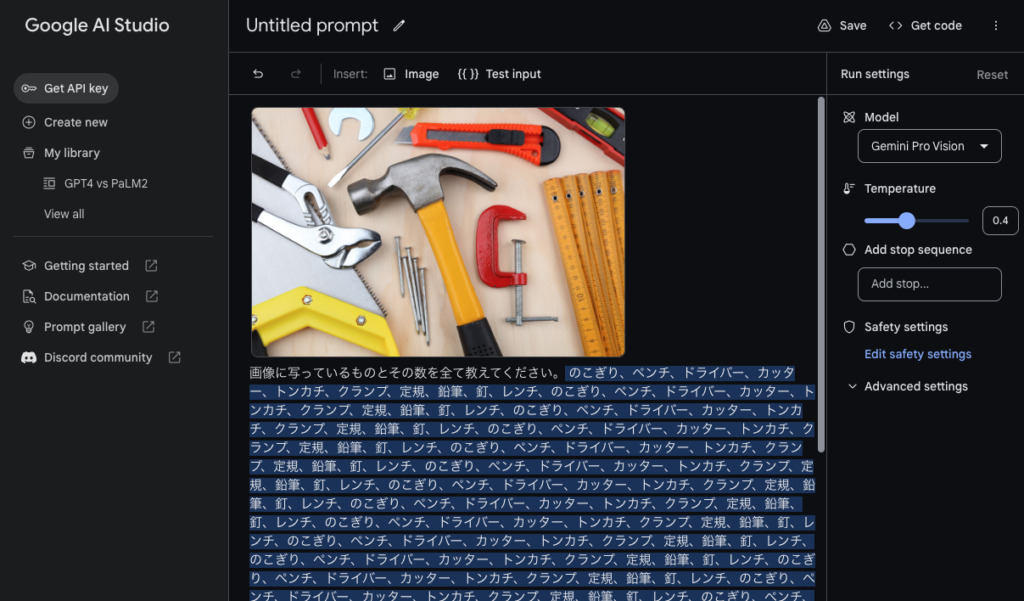

バグりました。

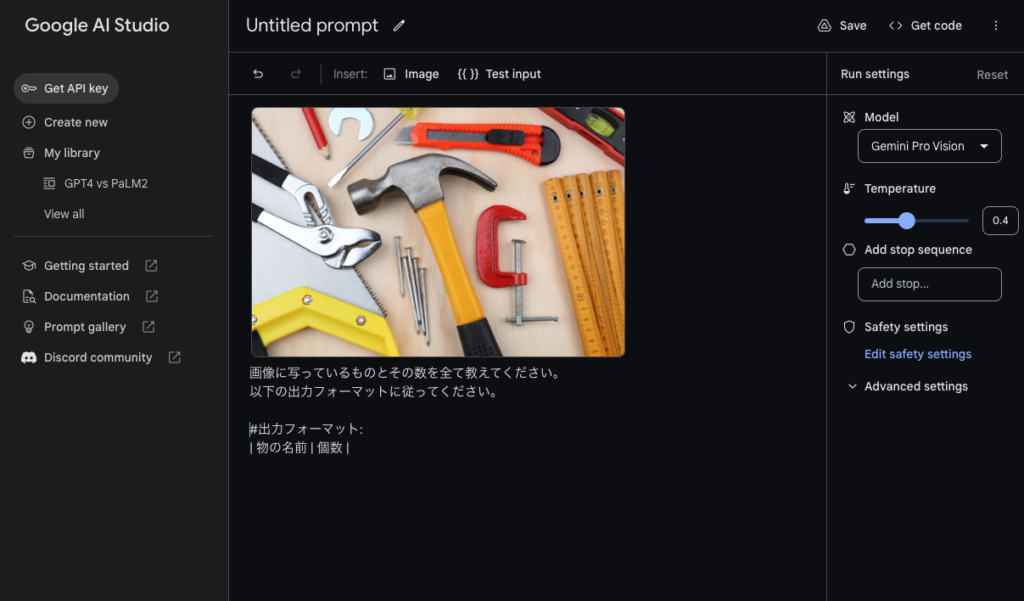

ちゃんと整えてみます。

いまいちですね。まだ不親切です。

気を取り直してもう一度。

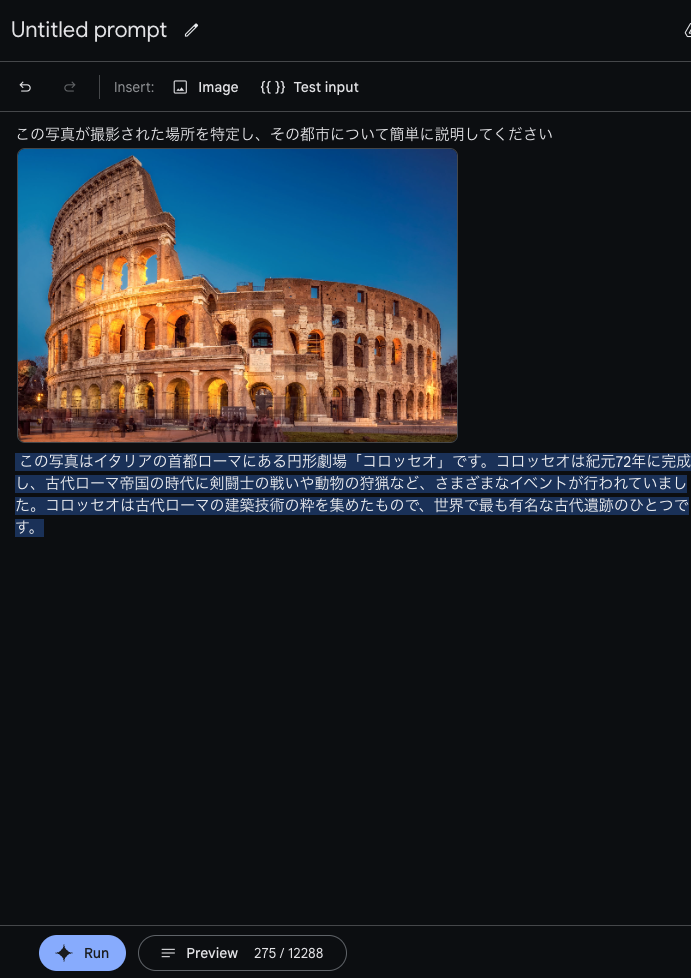

テンプレに従い「この写真が撮影された場所を特定し、その都市について簡単に説明してください」と聞いてみます。

この写真はイタリアの首都ローマにある円形劇場「コロッセオ」です。コロッセオは紀元72年に完成し、古代ローマ帝国の時代に剣闘士の戦いや動物の狩猟など、さまざまなイベントが行われていました。コロッセオは古代ローマの建築技術の粋を集めたもので、世界で最も有名な古代遺跡のひとつです。

Gemini Pro

可能性を感じてきました。

画像の前に質問を持ってくると良さそうです。

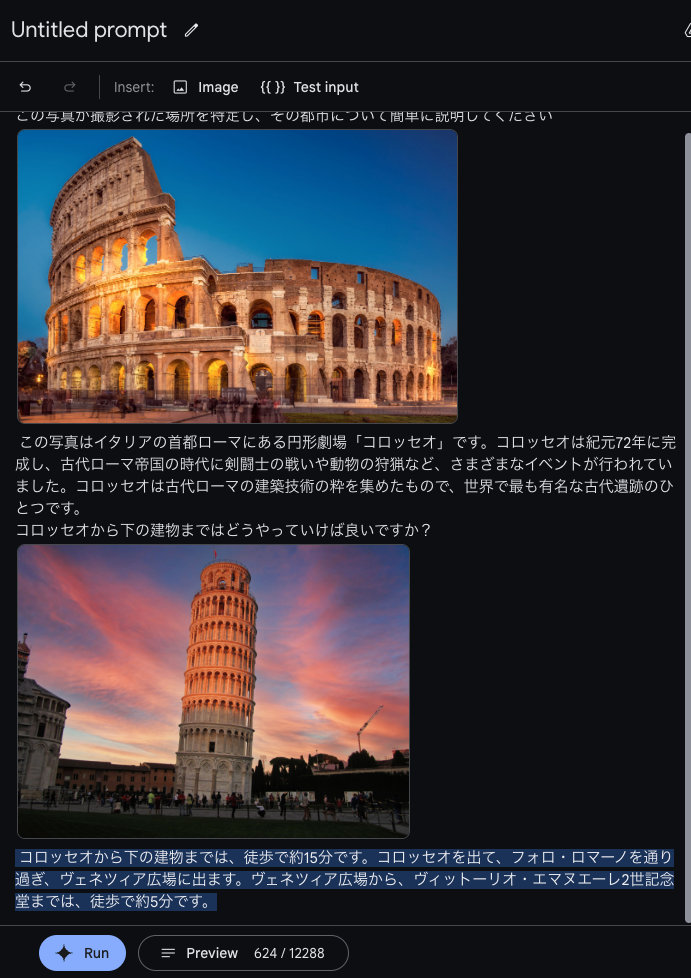

わかりにくいですが「コロッセオから下の建物まではどうやっていけば良いですか?」と聞いています。

ヴィットーリオ・エマヌエーレ2世記念同ではなくピサの斜塔だと思いますが、ピサの斜塔だとすると徒歩3日ぐらいみたいです。

コツを掴んできた

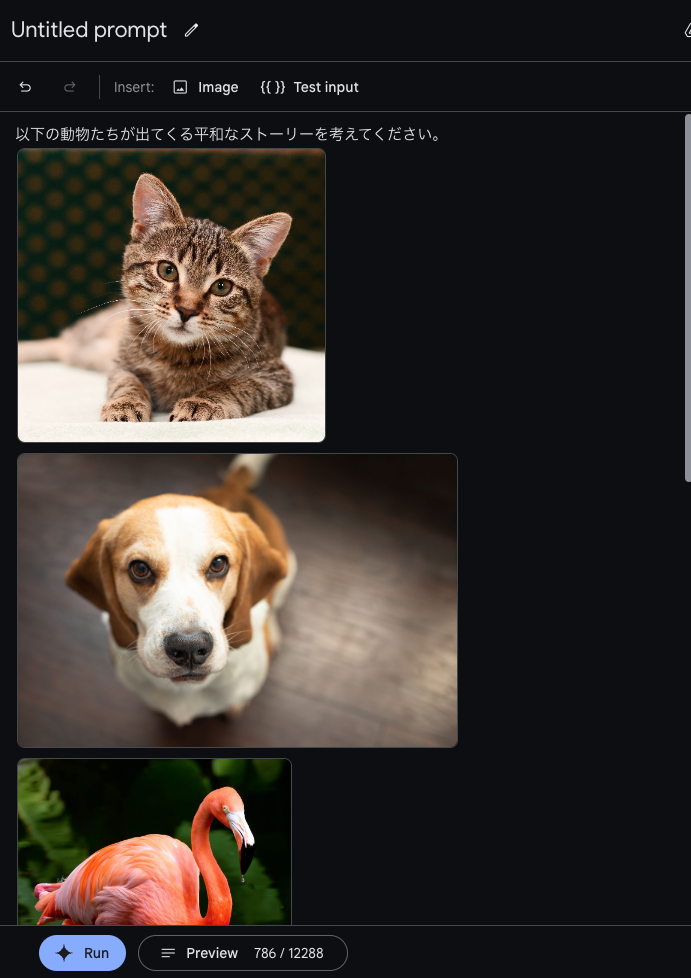

猫と犬とフラミンゴの写真を使用してストーリーテラーになってもらいます。

猫のミミ、犬のポチ、フラミンゴのフラミンは、仲良し3人組です。

Gemini Pro

ある日、ミミとポチが遊んでいると、フラミンがやってきました。

「こんにちは、フラミン」とミミが言いました。

「こんにちは、ミミとポチ」とフラミンが言いました。

「一緒に遊びませんか?」とポチが言いました。

「いいよ」とフラミンが言いました。

3匹は一緒に遊びました。

鬼ごっこをしたり、かくれんぼをしたり、とても楽しかったです。

遊んでいると、ミミが「おなかがすいたな」と言いました。

「私も」とポチとフラミンが言いました。

3匹はご飯を食べに行きました。

ご飯を食べた後、3匹はまた遊びました。

今度は、ブランコに乗ったり、滑り台を滑ったりしました。

3匹はとても楽しかったです。

日が暮れてきたので、3匹はお別れをしました。

「また明日遊ぼうね」とミミが言いました。

「うん、またね」とポチとフラミンが言いました。

3匹はそれぞれの家へと帰りました。

3匹は、また明日遊べることを楽しみにしながら、眠りました。

まとめ

LLMではなくてマルチモーダルAIと言っていた意味がなんとなくわかりました。

知識なしで、従来のLLMと同じように使用するタイプではなさそうです。

今回は何も知らずに使用したので何も有意義な情報はないですが、当分は自然言語処理のできるモデルだったとしてもそのモデルに対する、より深い知識が必要そうです。

関連記事:プロンプト文例集「プロンプトパーク」の使い方・おすすめの人を紹介!